Использование нечеткой искусственной нейронной сети TSK (Takagi, Sugeno, Kang’a) в задаче прогнозирования валютных курсов

1) Обучение проводится с учителем. Т.е. для каждого входного вектора имеется желаемое для выхода значение.

2) Выборка разбивается на 2 части: обучающая и проверочная.

Обобщенную схему вывода в модели TSK при использовании ![]() правил и

правил и ![]() переменных

переменных t=25 src="images/referats/8196/image004.png">можно представить в следующем виде:

![]() , то

, то ![]() ;

;

![]() , то

, то ![]()

где ![]() - значение лингвистической переменной

- значение лингвистической переменной ![]() для правила

для правила ![]() с функцией принадлежности (ФП)

с функцией принадлежности (ФП)

,

, ![]() ,

, ![]()

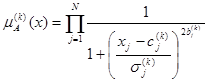

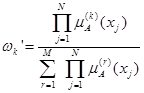

В нечеткой нейронной сети TSK пересечение правил ![]() определяется ФП в форме произведения, т.е.

определяется ФП в форме произведения, т.е.

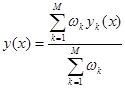

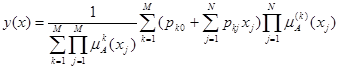

При ![]() правилах вывода композиция исходных результатов сети определяется по следующей формуле (аналогично выводу Сугено):

правилах вывода композиция исходных результатов сети определяется по следующей формуле (аналогично выводу Сугено):

где ![]() ,

, ![]()

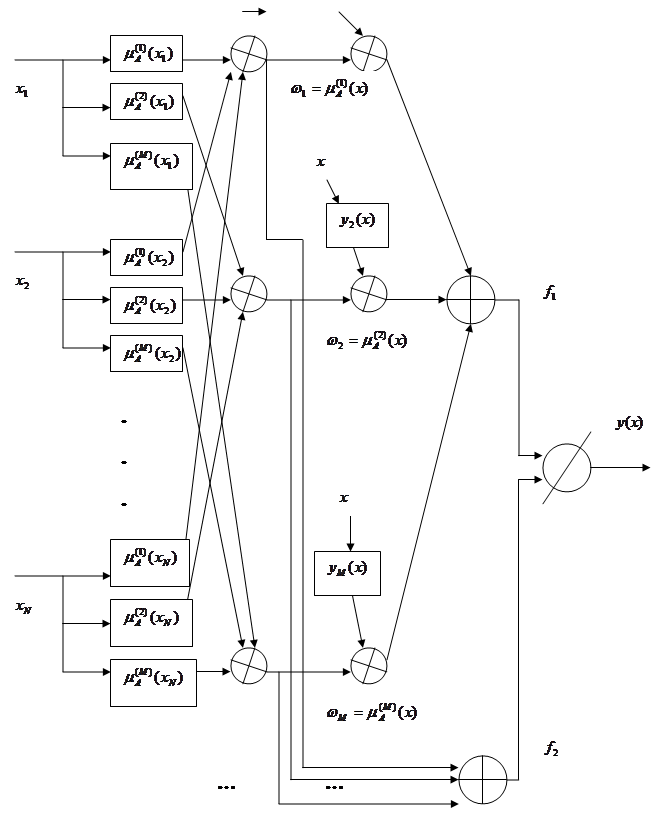

Нечеткая нейронная сеть TSK задается многослойной структурной сетью, представленной на рисунке 1. В такой сети выделяют 5 слоев.

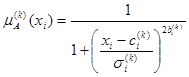

1. Первый слой выполняет раздельную фаззификацию каждой переменной ![]() ,

, ![]() , определяя для каждого

, определяя для каждого ![]() -го правила вывода значение ФП

-го правила вывода значение ФП ![]() в соответствии с функцией фаззификации. Это параметрический слой с параметрами

в соответствии с функцией фаззификации. Это параметрический слой с параметрами ![]() , которые подлежат адаптации в процессе обучения.

, которые подлежат адаптации в процессе обучения.

2. Второй слой выполняет агрегирование отдельных переменных ![]() , определяя результирующую степень принадлежности

, определяя результирующую степень принадлежности ![]() для вектора

для вектора ![]() условиям

условиям ![]() -го правила. Это не параметрический слой.

-го правила. Это не параметрический слой.

3. Третий слой представляет собой генератор функции TSK, в котором рассчитывается значения ![]() . В этом слое также происходит умножение функции

. В этом слое также происходит умножение функции ![]() на

на ![]() , сформированных на предыдущем слое. Это параметрический слой, в котором адаптации подлежат линейные параметры (веса),

, сформированных на предыдущем слое. Это параметрический слой, в котором адаптации подлежат линейные параметры (веса), ![]() для

для ![]() ,

, ![]() , определяющие функции последствий правил.

, определяющие функции последствий правил.

4. Четвертый слой составляют 2 нейрона-сумматора, один из которых рассчитывает взвешенную сумму сигналов ![]() , а второй определяет сумму весов

, а второй определяет сумму весов ![]() .

.

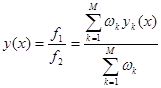

5. Пятый слой состоит из одного единственного нейрона. В нем веса подлежат нормализации и вычисляется выходной сигнал ![]() в соответствием с выражением

в соответствием с выражением

Это так же не параметрический слой.

Из приведенного описания следует, что нечеткая сеть TSK содержит только 2 параметрических слоя (первый и третий), параметры которых уточняются в процессе обучения. Параметры первого слоя (![]() ) будем называть нелинейными, а параметры третьего слоя

) будем называть нелинейными, а параметры третьего слоя ![]() - линейными весами.

- линейными весами.

Общее выражение для функциональной зависимости для сети TSK задается так:

|

|

Рисунок 1. Структура ННС TSK

3.3 Алгоритм обучения

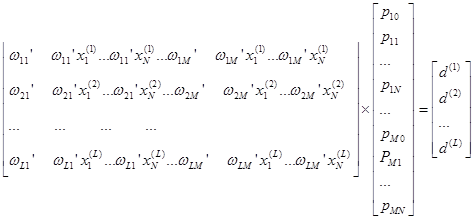

Рассмотрим гибридный алгоритм обучения. В гибридном алгоритме параметры, подлежащие адаптации, делятся на 2 группы. Первая из них состоит из линейных параметров ![]() третьего слоя, а вторая группа – из параметров нелинейной ФП первого слоя. Уточнение параметров происходит в 2 этапа.

третьего слоя, а вторая группа – из параметров нелинейной ФП первого слоя. Уточнение параметров происходит в 2 этапа.

На первом этапе при фиксации отдельных значений параметров функции принадлежности, решая систему линейных уравнений, рассчитываются линейные параметры ![]() полинома TSK. При известных значениях ФП зависимость для выхода можно представить в виде линейной формы относительно параметра

полинома TSK. При известных значениях ФП зависимость для выхода можно представить в виде линейной формы относительно параметра ![]() :

:

![]() , где

, где  ,

, ![]()

При размерности обучающей выборки ![]() ,

, ![]() и замене выходного сигнала сети ожидаемым значением

и замене выходного сигнала сети ожидаемым значением ![]() получим систему из

получим систему из ![]() линейных уравнений вида

линейных уравнений вида

Другие рефераты на тему «Программирование, компьютеры и кибернетика»:

- Исследование процессов маршрутизации

- Развитие систем управления базами данных

- Контекстные диаграммы отпуска товара со склада

- Анализ системы автоматизации розничной торговли

- Анализ процесса регулирования непрерывной системы. Анализ процесса управление цифровой системы и синтез передаточной функции корректирующего цифрового устройства управления

Поиск рефератов

Последние рефераты раздела

- Основные этапы объектно-ориентированного проектирования

- Основные структуры языка Java

- Основные принципы разработки графического пользовательского интерфейса

- Основы дискретной математики

- Программное обеспечение системы принятия решений адаптивного робота

- Программное обеспечение

- Проблемы сохранности информации в процессе предпринимательской деятельности