Мультиколлинеарность

Мультиколлинеарность

Под мультиколлинеарностью понимается высокая взаимная коррелированность объясняющих переменных. Мультиколлинеарность может проявляться в функциональной (явной) и стохастической (скрытой) формах.

При функциональной форме мультиколлинеарности по крайней мере одна из парных связей между объясняющими переменными является линейной функциональной за

висимостью. В этом случае матрица X`X особенная, так как содержит линейно зависимые векторы-столбцы, и её определитель равен нулю, т.е. нарушается предпосылка регрессионного анализа, это приводит к невозможности решения соответствующей системы нормальных уравнений и получения оценок параметров регрессионной модели.

Однако в экономических исследованиях мультиколлинеарность чаще проявляется в стохастической форме, когда между хотя бы двумя объясняющими переменными существует тесная корреляционная связь. Матрица X`X в этом случае является неособенной, но её определитель очень мал.

В то же время вектор оценок b и его ковариционная матрица ∑b пропорциональны обратной матрице (X`X)-1, а значит, их элементы обратно пропорциональны величине определителя |X`X|. В результате получаются значительные средние квадратические отклонения (стандартные ошибки) коэффициентов регрессии b0, b1,…,bp и оценка их значимости по t-критерию не имеет смысла, хотя в целом регрессионная модель может оказаться значимой по F-критерию.

Оценки становятся очень чувствительными к незначительному изменению результатов наблюдений и объёма выборки. Уравнения регрессии в этом случае, как правило, не имеют реального смысла, так как некоторые из его коэффициентов могут иметь неправильные с точки зрения экономической теории знаки и неоправданно большие значения.

Точных количественных критериев для определения наличия или отсутствия мультиколлинеарности не существует. Тем не менее, имеются некоторые эвристические подходы по её выявлению.

Один из таких подходов заключается в анализе корреляционной матрицы между объясняющими переменными X1,X2,…,Xp и выявлении пар переменных, имеющих высокие переменные корреляции (обычно больше 0,8). Если такие переменные существуют, говорят о мультиколлинеарности между ними. Полезно также находить множественные коэффициенты детерминации между одной из объясняющих переменных и некоторой группой из них. Наличие высокого множественного коэффициента детерминации (обычно больше 0,6) свидетельствует о мультиколлинеарности.

Другой подход состоит в исследовании матрицы X`X. Если определитель матрицы X`X либо её минимальное собственное значение λmin близки к нулю ( например одного порядка с накапливающимися ошибками вычислений), то это говорит о наличии мультиколлинеарности. о том же может свидетельствовать и значительное отклонение максимального собственного значения λmax матрицы X`X от её минимального собственного значения λmin.

Для устранения или уменьшения мультиколлинеарности используется ряд методов. Самый простой из них (но далеко не всегда возможный) состоит в том, что из двух объясняющих переменных, имеющих высокий коэффициент корреляции (больше 0,8), одну переменную исключают из рассмотрения. При этом, какую переменную оставить, а какую удалить из анализа, решают в первую очередь на основании экономических соображений. Если с экономической точки зрения ни одной из переменных нельзя отдать предпочтение, то оставляют ту из двух переменных, которая имеет больший коэффициент корреляции с зависимой переменной.

Другой метод устранения или уменьшения мультиколлинеарности заключается в переходе от несмещённых оценок, определённых по методу наименьших квадратов, к смещённым оценкам, обладающим, однако, меньшим рассеянием относительно оцениваемого параметра, т.е. меньшим математическим ожиданием квадрата отклонения оценки bj от параметра βj или M (bj - βj)2.

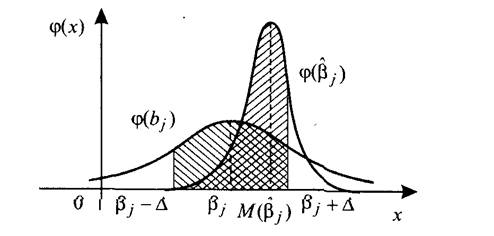

Оценки, определяемые вектором, обладают в соответствии с теоремой Гаусса-Маркова минимальными дисперсиями в классе всех линейных несмещённых оценок, но при наличии мультиколлинеарности эти дисперсии могут оказаться слишком большими, и обращение к соответствующим смещённым оценкам может повысить точность оценивания параметров регрессии. На рисунке показан случай, когда смещённая оценка βj^, выборочное распределение которой задаётся плотностью φ ( βj^).

Действительно, пусть максимально допустимый по величине доверительный интервал для оцениваемого параметра βj есть (βj-Δ, βj+Δ). Тогда доверительная вероятность, или надёжность оценки, определяемая площадью под кривой распределения на интервале (βj-Δ, βj+Δ), как нетрудно видеть из рисунка, будет в данном случае больше для оценки βj по сравнению с bj ( на рисунке эти площади заштрихованы). Соответственно средний квадрат отклонения оценки от оцениваемого параметра будет меньше для смещённой оценки, т.е.:

M ( βj^- βj )2 < M ( bj - βj )2

При использовании «ридж-регрессии» (или «гребневой регрессии») вместо несмещённых оценок рассматривают смещённые оценки, задаваемые вектором

βτ^=( X`X+τ Ep+1)-1 X`Y,

где τ – некоторое положительное число, называемое «гребнем» или «хребтом»,

Ep+1 – единичная матрица (р+1) –го порядка.

Добавление τ к диагональным элементам матрицы X`X делает оценки параметров модели смещёнными, но при этом увеличивается определитель матрицы системы нормальных уравнений – вместо (X`X) от будет равен

|X`X+τ Ep+1|

Таким образом, становится возможным исключение мультиколлинеарности в случае, когда определитель |X`X| близок к нулю.

Для устранения мультиколлинеарности может быть использован переход от исходных объясняющих переменных X1,X2,…,Xn, связанных между собой достаточно тесной корреляционной зависимостью, к новым переменным, представляющим линейные комбинации исходных. При этом новые переменные должны быть слабо коррелированными либо вообще некоррелированными. В качестве таких переменных берут, например, так называемые главные компоненты вектора исходных объясняющих переменных, изучаемые в компонентном анализе, и рассматривают регрессию на главных компонентах, в которой последние выступают в качестве обобщённых объясняющих переменных, подлежащих в дальнейшем содержательной (экономической) интерпритации.

Ортогональность главных компонент предотвращает проявление эффекта мультиколлинеарности. Кроме того, применяемый метод позволяет ограничиться малым числом главных компонент при сранительно большом количестве исходных объясняющих переменных.

Мультиколлинеарность — это понятие, которое используется для описания проблемы, когда нестрогая линейная зависимость между объясняющими переменными приводит к получению ненадежных оценок регрессии. Разумеется, такая зависимость совсем необязательно дает неудовлетворительные оценки. Если все другие условия благоприятствуют, т. е. если число наблюдений и выборочные дисперсии объясняющих переменных велики, а дисперсия случайного члена —мала, то в итоге можно получить вполне хорошие оценки.

Другие рефераты на тему «Экономико-математическое моделирование»:

- Разработка имитационной модели грузового терминала

- Характеристика изменения социально-экономических показателей

- Экономико-математическая задача по оптимизации рационов кормления

- Регрессионный анализ. Парная регрессия

- Математическая модель в пространстве состояний линейного стационарного объекта управления

Поиск рефератов

Последние рефераты раздела

- Выборочные исследования в эконометрике

- Временные характеристики и функция времени. Графическое представление частотных характеристик

- Автоматизированный априорный анализ статистической совокупности в среде MS Excel

- Биматричные игры. Поиск равновесных ситуаций

- Анализ рядов распределения

- Анализ состояния финансовых рынков на основе методов нелинейной динамики

- Безработица - основные определения и измерение. Потоки, запасы, утечки, инъекции в модели