Статистические способы обработки экспериментальных данных

1.4 Разброс выборки

Разброс (иногда эту величину называют размахом) выборки обозначается буквой R. Это самый простой показатель, который можно получить для выборки - разность между максимальной и минимальной величинами данного конкретного вариационного ряда, т.е.

R= хmax - хmin

Понятно, что чем сильнее варьирует измеряемый признак, тем больше величина R, и наоборот. Однако мо

жет случиться так, что у двух выборочных рядов и средние, и размах совпадают, однако характер варьирования этих рядов будет различный. Например, даны две выборки:

Х = 10 15 20 25 30 35 40 45 50X = 30 R = 40

Y = 10 28 28 30 30 30 32 32 50 Y=30 R = 40

При равенстве средних и разбросов для этих двух выборочных рядов характер их варьирования различен. Для того чтобы более четко представлять характер варьирования выборок, следует обратиться к их распределениям.

1.5 Дисперсия

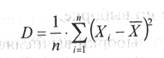

Дисперсия - это среднее арифметическое квадратов отклонений значений переменной от её среднего значения.

Дисперсия как статистическая величина характеризует, насколько частные значения отклоняются от средней величины в данной выборке. Чем больше дисперсия, тем больше отклонения или разброс данных.

где 5 - выборочная дисперсия, или просто дисперсия;

2 (……) - выражение, означающее, что для всех х, от первого до последнего в данной выборке необходимо вычислить разности между частными и средними значениями, возвести эти разности в квадрат и просуммировать;

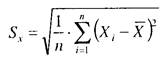

п - количество испытуемых в выборке или первичных значений, по которым вычисляется дисперсия. Однако сама дисперсия, как характеристика отклонения от среднего, часто неудобна для интерпретации. Для того, чтобы приблизить размерность дисперсии к размерности измеряемого признака применяют операцию извлечения квадратного корня из дисперсии. Полученную величину называют стандартным отклонением.

Из суммы квадратов, делённых на число членв ряда извлекаеся квадратный корень.

Иногда исходных частных первичных данных, которые подлежат статистической обработке, бывает довольно много, и они требуют проведения огромного количества элементарных арифметических операций. Для того чтобы сократить их число и вместе с тем сохранить нужную точность расчетов, иногда прибегают к замене исходной выборки частных эмпирических данных на интервалы. Интервалом называется группа упорядоченных по величине значений признака, заменяемая в процессе расчетов средним значением.

2. Методы вторичной статистической обработки результатов эксперимента

С помощью вторичных методов статистической обработки экспериментальных данных непосредственно проверяются, доказываются или опровергаются гипотезы, связанные с экспериментом. Эти методы, как правило, сложнее, чем методы первичной статистической обработки, и требуют от исследователя хорошей подготовки в области элементарной математики и статистики. (7).

Обсуждаемую группу методов можно разделить на несколько подгрупп:

1. Регрессионное исчисление.

2. Методы сравнения между собой двух или нескольких элементарных статистик (средних, дисперсий и т.п.), относящихся к разным выборкам.

3. Методы установления статистических взаимосвязей между переменными, например их корреляции друг с другом.

4. Методы выявления внутренней статистической структуры эмпирических данных (например, факторный анализ). Рассмотрим каждую из выделенных подгрупп методов вторичной статистической обработки на примерах.

2.1 Регрессионное исчисление

Регрессионное исчисление - это метод математической статистики, позволяющий свести частные, разрозненные данные к некоторому линейному графику, приблизительно отражающему их внутреннюю взаимосвязь, и получить возможность по значению одной из переменных приблизительно оценивать вероятное значение другой переменной (7).

Графическое выражение регрессионного уравнения называют линией регрессии. Линия регрессии выражает наилучшие предсказания зависимой переменой (Y) по независимым переменным (X).

Регрессию выражают с помощью двух уравнений регрессии, которые в самом прямом случае выглядят, как уравнения прямой.

Y = a 0 + a 1 * X (1)

X = b 0 + b 1 * Y (2)

В уравнении (1) Y - зависимая переменная, X - независимая переменная, a 0 - свободный член, a 1 - коэффициент регрессии, или угловой коэффициент, определяющий наклон линии регрессии по отношению к осям координат.

В уравнении (2) X - зависимая переменная, Y - независимая переменная, b 0 - свободный член, b 1 - коэффициент регрессии, или угловой коэффициент, определяющий наклон линии регрессии по отношению к осям координат.

Количественное представление связи (зависимости) между Х и Y (между Y и X) называется регрессионным анализом. Главная задача регрессионного анализа заключается в нахождении коэффициентов a 0, b 0, a1и b 1 и определении уровня значимости полученных аналитических выражений, связывающих между собой переменные Х и У.

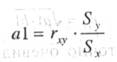

При этом коэффициенты регрессии a 1 и b 1 показывают, насколько в среднем величина одной переменной изменяется при изменении на единицу меры другой. Коэффициент регрессии a 1 в уравнении можно подсчитать по формуле:

а коэффициент b 1 в уравнении по формуле

где ryx - коэффициент корреляции между переменными X и Y;

Sx - среднеквадратическое отклонение, подсчитанное для переменной X;

Sy - среднеквадратическое отклонение, подсчитанное для переменной У/

Для применения метода линейного регрессионного анализа необходимо соблюдать следующие условия:

1. Сравниваемые переменные Х и Y должны быть измерены в шкале интервалов или отношений.

2. Предполагается, что переменные Х и Y имеют нормальный закон распределения.

3. Число варьирующих признаков в сравниваемых переменных должно быть одинаковым. (5).

2.2 Корреляция

Следующий метод вторичной статистической обработки, посредством которого выясняется связь или прямая зависимость между двумя рядами экспериментальных данных, носит название метод корреляций. Он показывает, каким образом одно явление влияет на другое или связано с ним в своей динамике. Подобного рода зависимости существуют, к примеру, между величинами, находящимися в причинно-следственных связях друг с другом. Если выясняется, что два явления статистически достоверно коррелируют друг с другом и если при этом есть уверенность в том, что одно из них может выступать в качестве причины другого явления, то отсюда определенно следует вывод о наличии между ними причинно-следственной зависимости. (7)

Когда повышение уровня одной переменной сопровождается повышением уровня другой, то речь идёт о положительной корреляции. Если же рост одной переменной происходит при снижении уровня другой, то говорят об отрицательной корреляции. При отсутствии связи переменных мы имеем дело с нулевой корреляцией. (1)

Другие рефераты на тему «Психология»:

Поиск рефератов

Последние рефераты раздела

- Взаимосвязь эмоционального интеллекта и агрессивности у студентов факультета психология

- Инженерия интимно-личностного общения и ее инструменты

- Я, Госпожа Удачи!

- Аналитическая психология Юнга

- Взаимодействие преподавателей и студентов в вузе

- Взаимосвязь эмоционального интеллекта и тревоги у студентов

- Влияние психологической среды ВУЗа